mow

|

github.com/Genio-The-Haiku-IDE/Genio/releases

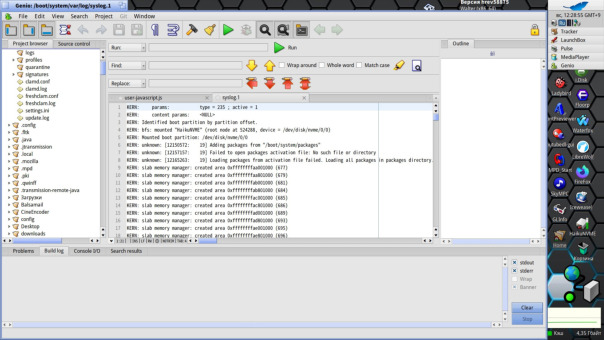

24 мая 2025 года состоялся очередной релиз интегрированной среды разработки с открытым исходным кодом - Haiku IDE - "Genio" |